Garis Besar Singkat

Posting ini akan menunjukkan:

Bagaimana Menerapkan Logika ReAct Dengan Penyimpanan Dokumen di LangChain

- Menginstal Kerangka

- Menyediakan Kunci API OpenAI

- Mengimpor Perpustakaan

- Menggunakan Penjelajah Wikipedia

- Menguji Model

Bagaimana Mengimplementasikan Logika ReAct Dengan Penyimpanan Dokumen di LangChain?

Model bahasa dilatih pada kumpulan besar data yang ditulis dalam bahasa alami seperti bahasa Inggris, dll. Data dikelola dan disimpan di penyimpanan dokumen dan pengguna cukup memuat data dari penyimpanan dan melatih model. Pelatihan model dapat memerlukan beberapa iterasi karena setiap iterasi membuat model lebih efektif dan ditingkatkan.

Untuk mempelajari proses penerapan logika ReAct untuk bekerja dengan penyimpanan dokumen di LangChain, cukup ikuti panduan sederhana ini:

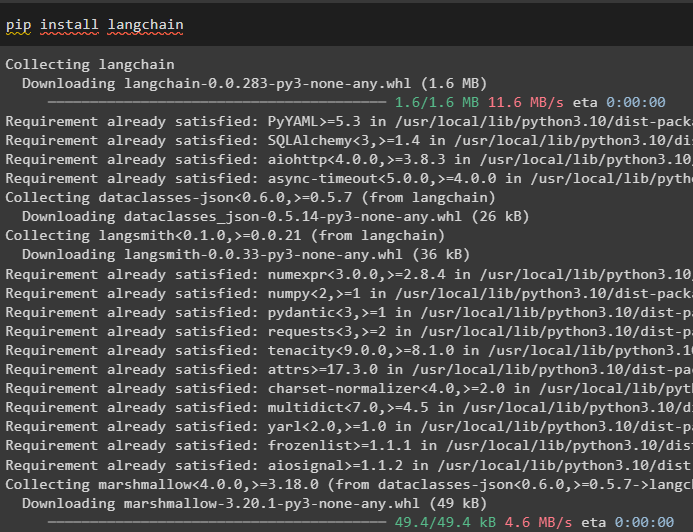

Langkah 1: Menginstal Kerangka

Pertama, mulailah proses penerapan logika ReAct untuk bekerja dengan penyimpanan dokumen dengan menginstal kerangka LangChain. Menginstal kerangka LangChain akan mendapatkan semua dependensi yang diperlukan untuk mendapatkan atau mengimpor perpustakaan untuk menyelesaikan proses:

pip instal langchain

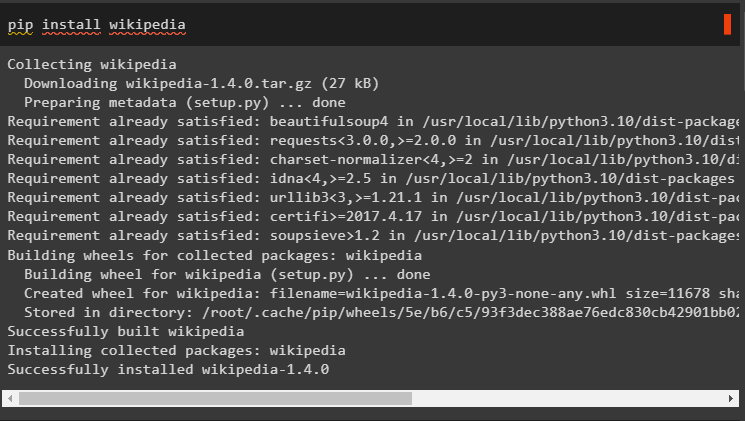

Instal dependensi Wikipedia untuk panduan ini karena dapat digunakan agar penyimpanan dokumen berfungsi dengan logika ReAct:

pip instal wikipedia

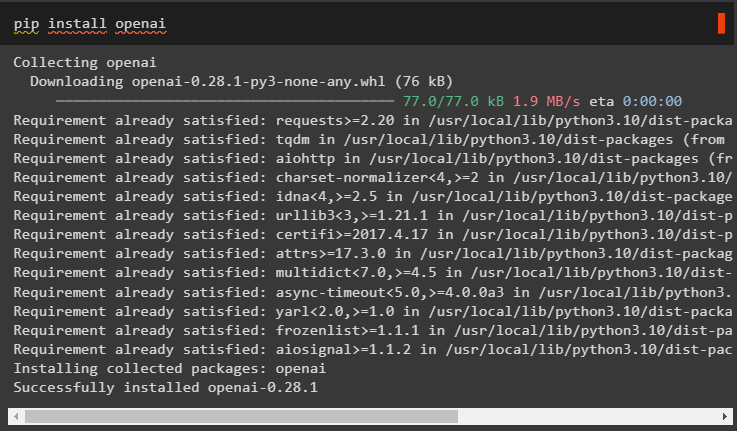

Instal modul OpenAI menggunakan perintah pip untuk mendapatkan perpustakaannya dan membangun Model Bahasa Besar atau LLM:

pip instal openai

Langkah 2: Menyediakan Kunci API OpenAI

Setelah menginstal semua modul yang diperlukan, cukup mengatur lingkungan menggunakan kunci API dari akun OpenAI menggunakan kode berikut:

impor Andaimpor dapatkan pass

Anda . sekitar [ 'OPENAI_API_KEY' ] = dapatkan pass . dapatkan pass ( 'Kunci API OpenAI:' )

Langkah 3: Mengimpor Perpustakaan

Setelah lingkungan diatur, impor perpustakaan dari LangChain yang diperlukan untuk mengonfigurasi logika ReAct untuk bekerja dengan penyimpanan dokumen. Menggunakan agen LangChain untuk mendapatkan DocstoreExplaorer dan agen dengan tipenya untuk mengonfigurasi model bahasa:

dari rantailang. llms impor OpenAIdari rantailang. toko dokumen impor Wikipedia

dari rantailang. agen impor inisialisasi_agent , Alat

dari rantailang. agen impor Tipe Agen

dari rantailang. agen . reaksi . basis impor Penjelajah Docstore

Langkah 4: Menggunakan Penjelajah Wikipedia

Konfigurasikan “ toko dokumen ” variabel dengan metode DocstoreExplorer() dan memanggil metode Wikipedia() dalam argumennya. Bangun Model Bahasa Besar menggunakan metode OpenAI dengan “ teks-davinci-002 ” model setelah mengatur alat untuk agen:

toko dokumen = Penjelajah Docstore ( Wikipedia ( ) )peralatan = [

Alat (

nama = 'Mencari' ,

fungsi = toko dokumen. mencari ,

keterangan = 'Ini digunakan untuk menanyakan pertanyaan/perintah dengan pencarian' ,

) ,

Alat (

nama = 'Lihatlah' ,

fungsi = toko dokumen. Lihatlah ,

keterangan = 'Ini digunakan untuk menanyakan pertanyaan/perintah dengan pencarian' ,

) ,

]

llm = OpenAI ( suhu = 0 , nama model = 'teks-davinci-002' )

#mendefinisikan variabel dengan mengkonfigurasi model dengan agen

reaksi = inisialisasi_agent ( peralatan , llm , agen = Tipe Agen. REACT_DOCSTORE , bertele-tele = BENAR )

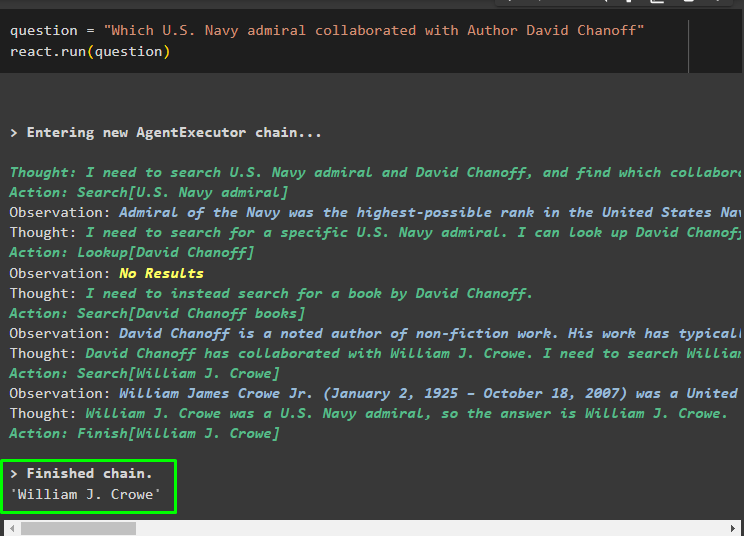

Langkah 5: Menguji Model

Setelah model dibuat dan dikonfigurasi, atur string pertanyaan dan jalankan metode dengan variabel pertanyaan dalam argumennya:

pertanyaan = 'Laksamana Angkatan Laut AS mana yang berkolaborasi dengan Penulis David Chanoff'reaksi. berlari ( pertanyaan )

Setelah variabel pertanyaan dieksekusi, model telah memahami pertanyaan tersebut tanpa template atau pelatihan prompt eksternal. Model dilatih secara otomatis menggunakan model yang diunggah pada langkah sebelumnya dan menghasilkan teks yang sesuai. Logika ReAct bekerja dengan penyimpanan dokumen untuk mengekstrak informasi berdasarkan pertanyaan:

Ajukan pertanyaan lain dari data yang diberikan ke model dari penyimpanan dokumen dan model akan mengekstrak jawabannya dari penyimpanan:

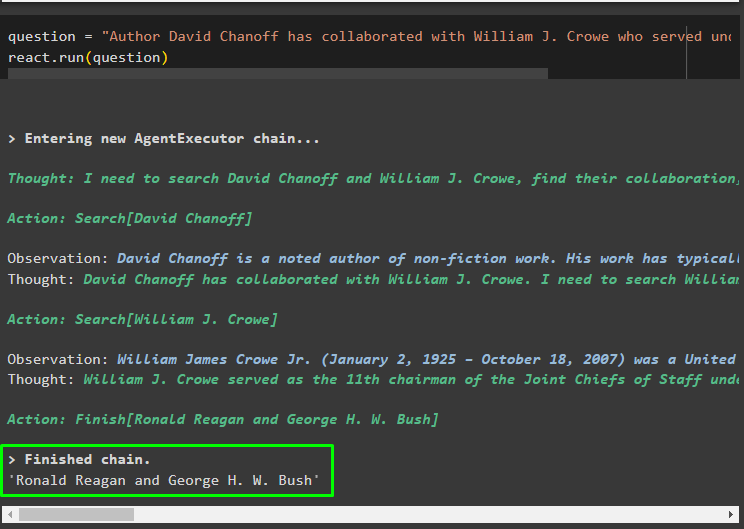

pertanyaan = 'Penulis David Chanoff pernah berkolaborasi dengan William J Crowe yang menjabat di bawah Presiden yang mana?'reaksi. berlari ( pertanyaan )

Sekian tentang penerapan logika ReAct untuk bekerja dengan penyimpanan dokumen di LangChain.

Kesimpulan

Untuk mengimplementasikan logika ReAct untuk bekerja dengan penyimpanan dokumen di LangChain, instal modul atau kerangka kerja untuk membangun model bahasa. Setelah itu, siapkan lingkungan OpenAI untuk mengonfigurasi LLM dan memuat model dari penyimpanan dokumen untuk mengimplementasikan logika ReAct. Panduan ini telah menguraikan penerapan logika ReAct untuk bekerja dengan penyimpanan dokumen.