Sintaksis:

Seperti yang kita kenal dengan ChatGPT, kita tahu bahwa platform ini dimiliki oleh komunitas AI Terbuka dan menyediakan alat, arsitektur, API, dan beberapa kerangka kerja yang dapat kita manfaatkan dalam penerapan aplikasi kita dan model pemrosesan bahasa alami. Open AI menawarkan API yang melaluinya kita dapat menggunakan model AI dan NLP terlatih apa pun dari platform Open AI dan dapat membuatnya berfungsi untuk aplikasi kita seperti, misalnya, untuk memberikan prediksi pada data real-time. Demikian pula, GPT4All juga menyediakan penggunanya untuk mengintegrasikan model AI yang telah dilatih sebelumnya dengan berbagai aplikasi.

Model GPT4All dilatih dengan data terbatas dibandingkan dengan ChatGPT. Ini juga memiliki beberapa batasan kinerja dibandingkan dengan ChatGPT tetapi memungkinkan pengguna untuk menggunakan GPT pribadi mereka di perangkat keras lokal mereka dan tidak memerlukan koneksi jaringan apa pun. Dengan bantuan artikel ini, kita akan mengetahui bagaimana kita dapat menggunakan model GPT4All dalam skrip Python karena GPT4All memiliki ikatan resmi dengan Python yang berarti kita juga dapat menggunakan dan mengintegrasikan model GPT4All melalui skrip Python.

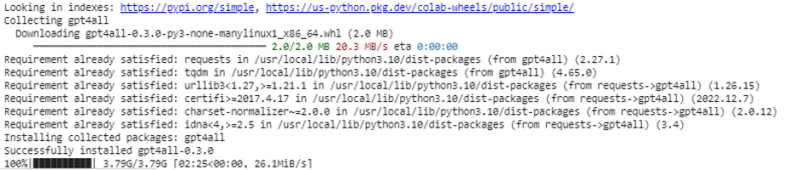

Semuanya membutuhkan perintah online untuk menginstal GPT4All untuk Python IDE. Kemudian, kami dapat mengintegrasikan model AI sebanyak aplikasi kami. Perintah untuk menginstal GPT4All ini dengan Python adalah seperti yang ditunjukkan berikut ini:

$ pip instal gpt4all

Contoh 1:

Untuk memulai dengan contoh ini, kita perlu mengunduh dan memasang Python di sistem kita. Versi Python yang direkomendasikan adalah 'versi 3.7' atau yang muncul setelah versi ini. Cara lain untuk bekerja dengan Python guna menghindari proses panjang penginstalan 'penyiapan Python' di sistem kami adalah menggunakan 'Google Colab' yang merupakan lingkungan berbasis cloud untuk Python. Kami dapat menjalankan lingkungan ini di browser web apa pun dan dapat membangun model AI dan pembelajaran mesin. Contoh yang akan kami terapkan di sini dijalankan di Google Colab.

Contoh ini mencakup metode untuk menginstal GPT4All dengan Python dan cara menggunakan model pra-terlatihnya. Kita mulai dengan menginstal GPT4All terlebih dahulu. Untuk itu, perintah yang kami sebutkan sebelumnya dijalankan. Dengan eksekusi perintah, GPT4All beserta paket dan kerangka kerjanya diunduh dan diinstal.

Sekarang, kita bergerak maju. Dari GPT4All, kami mengimpor 'GPT4All'. Ini menambahkan semua model terlatih dari GPT4All ke proyek. Sekarang, kami dapat menggunakan model tunggal apa pun dan membuatnya melakukan prediksi untuk aplikasi kami. Setelah kita mengimpor paket GPT4All, sekarang saatnya memanggil fungsi ini dan menggunakan model GPT4All yang memberikan output untuk 'penyelesaian obrolan'.

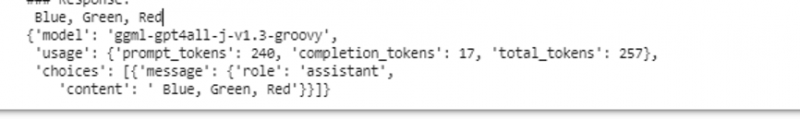

Dengan kata lain, jika kita menanyakan sesuatu dari model itu di input, model itu mengembalikannya di output. Model yang kami gunakan di sini adalah “ggml-gpt4all-j-v1.3-groovy”. Model ini sudah disimpan di cache GPT4All. Kita bisa mendapatkan model-model ini dari tautan ini “ https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” untuk pengunduhan manual. Jika model sudah ada di cache GPT4All, kita cukup memanggil nama model dan menetapkannya sebagai parameter input ke fungsi “GPT4All()”. Jika kami berhasil mengunduhnya secara manual, kami meneruskan jalur ke folder tempat model berada. Karena model ini untuk penyelesaian pesan, sintaks untuk model ini diberikan sebagai berikut:

$ Obrolan_penyelesaian (pesan)Pesan adalah daftar kamus dan setiap kamus harus berisi kunci 'peran' dengan nilai pengguna, sistem, atau asisten, dan konten 'kunci' yang memiliki nilai sebagai string. Dalam contoh ini, kami menetapkan konten sebagai 'nama tiga warna' dan kunci peran sebagai 'pengguna'.

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'user', 'content': 'Nama 3 bunga'}]

Setelah spesifikasi ini, kami memanggil fungsi 'chat_completion()' dengan model. Kode untuk ini ditampilkan dalam keluaran berikut:

$ !pip instal gpt4alldari gpt4all mengimpor GPT4All

model = GPT4All('ggml-gpt4all-j-v1.3-groovy')

pesan = [{'role': 'user', 'content': 'Sebutkan tiga warna'}]

model.chat_completion(pesan)

Setelah eksekusi contoh ini, model mengembalikan tiga warna sebagai respons terhadap input.

Contoh 2:

Kami membahas contoh lain di mana kami menemukan metode lain untuk menggunakan GPT4All dengan Python. Ini dapat dilakukan dengan menggunakan pengikatan resmi untuk Python yang disediakan oleh “Nomic” yang merupakan komunitas AI sumber terbuka, dan menjalankan GPT4All. Menggunakan perintah berikut, kami mengintegrasikan 'nomic' ke dalam konsol Python kami:

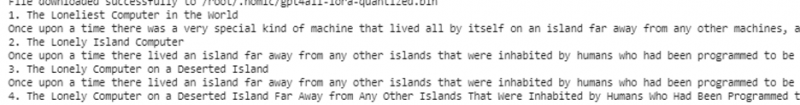

$ pip instal nomicSetelah diinstal, kami mengimpor GPT4All dari 'nomic.gpt4all'. Setelah mengimpor GPT4All, kami menginisialisasi GPT4All dengan fungsi “open()”. Kemudian, kami memanggil fungsi 'prompt()' dan meneruskan prompt ke fungsi ini. Kemudian, prompt response dihasilkan berdasarkan prompt yang telah kita berikan sebagai input ke model prompt.

!pip instal nomicdari nomic.gpt4all mengimpor GPT4All

# Inisialisasi model GPT4All

memulai = GPT4All()

memulai.buka()

# Menghasilkan respons berdasarkan prompt

model_response = inisiasi.prompt('menulis cerita pendek tentang komputer)

# menampilkan respons yang dihasilkan

cetak(model_response)

Outputnya menampilkan respons cepat dari model yang kami buat menggunakan model GPT4All pra-terlatih dengan Python. Jika kita ingin mengetahui lebih banyak tentang model dan bagaimana kita dapat menggunakan model ini untuk menghasilkan tanggapan, atau dengan kata sederhana, jika kita ingin mendapatkan pengetahuan tentang sintaks untuk menghasilkan tanggapan dari model ini, kita dapat mengambil bantuan lebih lanjut dari Detail dokumentasi teknis GPT4All.

Kesimpulan

GPT4All masih berusaha untuk mendapatkan akurasi performa. Ini dijalankan oleh platform AI nomic yang bertujuan untuk menyediakan chatbot cerdas artifisial kepada penggunanya pada CPU tingkat konsumen karena GPT4All bekerja tanpa koneksi jaringan dan GPU. Artikel ini mencerahkan kita untuk mahir menggunakan PyGPT4All di lingkungan Python dan untuk membuat interaksi antara aplikasi kita dan model AI GPT4All yang telah dilatih sebelumnya. Kami membahas dua metode berbeda tentang cara menginstal GPT4All dengan Python dalam panduan ini.