Di blog ini, kami akan membahas konten yang disediakan di bawah ini:

- Bagaimana Cara Menyesuaikan Pembuatan Teks dengan Memuat Model Dengan Fungsi 'pipeline' dari Transformers?

- Bagaimana Cara Memanfaatkan Model Berbasis Transformer untuk Menghasilkan Teks di PyTorch?

- Bagaimana Cara Memanfaatkan Model Berbasis Transformer untuk Menghasilkan Teks di TensorFlow?

Bagaimana Cara Menyesuaikan Pembuatan Teks dengan Memuat Model Dengan Fungsi 'pipa' dari Transformers?

“ saluran pipa Fungsi ” digunakan untuk mengunduh model AI terlatih secara otomatis sesuai dengan kebutuhan pengguna. Untuk menggunakan fungsi khusus ini, pengguna perlu menginstal “ transformator ” paket. Paket ini memberikan akses ke model berbasis Transformer canggih yang dapat melakukan analisis sentimen serta beberapa model lainnya Pemrosesan bahasa alami (NLP) tugas.

Untuk melihat demonstrasi praktis dari skenario yang dijelaskan di atas, lanjutkan ke langkah-langkah yang diberikan di bawah ini!

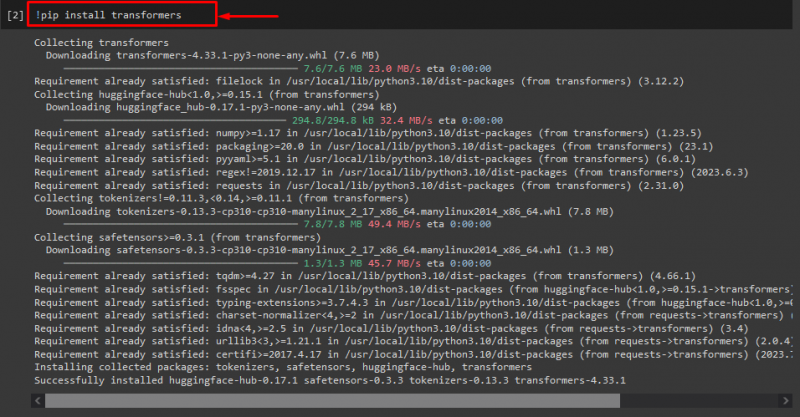

Langkah 1: Instal Paket “transformator”.

Awalnya, jalankan perintah “! pip” perintah untuk menginstal paket transformator:

! pip instal trafo

Seperti yang Anda lihat, paket yang ditentukan telah berhasil diinstal:

Langkah 2: Impor Model berbasis Transformer

Setelah itu, impor model berbasis transformator yang diperlukan. Untuk melakukannya, pertama-tama, impor “ saluran pipa ” berfungsi dari “ transformator ”. Selanjutnya, gunakan fungsi yang diimpor dan teruskan “ pembuatan teks ” sebagai argumen beserta nama model yang diperlukan “ gpt2 ”. Selanjutnya, berikan mereka ke “ menghasilkan ' variabel:

dari transformator impor saluran pipa

menghasilkan = saluran pipa ( 'pembuatan teks' , model = 'gpt2' )

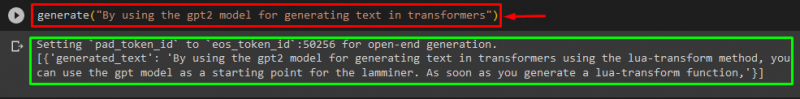

Langkah 3: Hasilkan Teks Kustomisasi

Sekarang, sampaikan teks yang diinginkan sebagai argumen ke “ menghasilkan ”. Seperti yang ditunjukkan di bawah ini:

menghasilkan ( 'Dengan menggunakan model gpt2 untuk menghasilkan teks di transformator' )Menurut keluaran yang diberikan, unduhan pra-pelatihan “ gpt3 ” model telah berhasil menghasilkan teks:

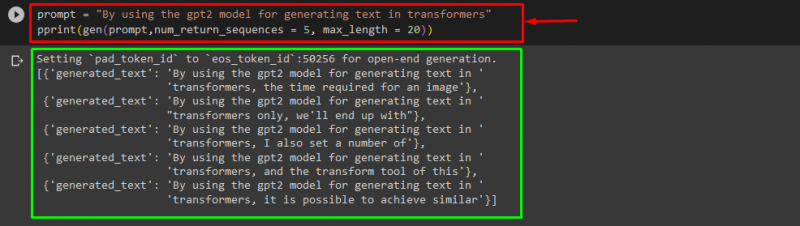

Anda juga dapat menggunakan argumen lain, seperti:

mengingatkan = 'Dengan menggunakan model gpt2 untuk menghasilkan teks di transformator'mencetak ( gen ( mengingatkan , nomor_return_sequences = 5 , panjang maksimal = dua puluh ) )

Di Sini:

- “ mengingatkan ” digunakan sebagai argumen yang menahan masukan.

- “ nomor_pengembalian_urutan Argumen ” digunakan untuk menghasilkan jumlah urutan teks yang disediakan.

- “ panjang maksimal Argumen ” digunakan untuk menentukan panjang teks yang dihasilkan. Dalam kasus kami, ini terbatas pada “ 30 ” token (kata atau tanda baca):

Catatan: Teks yang disesuaikan akan menjadi kelanjutan dari perintah tertentu yang didasarkan pada data pelatihan model.

Bagaimana Cara Memanfaatkan Model Berbasis Transformer untuk Menghasilkan Teks di PyTorch?

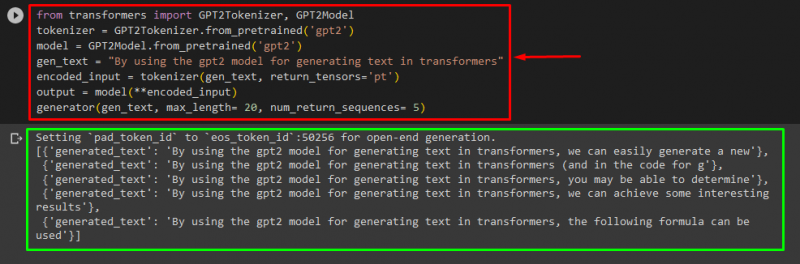

Pengguna juga dapat menyesuaikan teks di “ PyTorch ” yang merupakan “ Obor ” kerangka kerja pembelajaran mesin berbasis. Ini digunakan untuk berbagai aplikasi, seperti NLP dan Computer Vision. Untuk menggunakan model berbasis transformator untuk menyesuaikan teks di PyTorch, pertama-tama, impor “ GPT2Tokenizer ' Dan ' GPT2Model ” berfungsi dari “ transformator ”:

dari transformator impor GPT2Tokenizer , GPT2ModelKemudian, gunakan “ GPT2Tokenizer ” tokenizer sesuai dengan model terlatih yang kami inginkan bernama “ gpt2 ”:

tokenizer = GPT2Tokenizer. dari_dilatih sebelumnya ( 'gpt2' )Setelah itu, membuat instance bobot dari model yang telah dilatih sebelumnya:

model = GPT2Model. dari_dilatih sebelumnya ( 'gpt2' )Selanjutnya, nyatakan “ gen_teks ” variabel yang menampung teks yang ingin kita sesuaikan:

gen_teks = 'Dengan menggunakan model gpt2 untuk menghasilkan teks di transformator'Sekarang, lewati “ gen_teks ' Dan ' return_tensors='pt' ” sebagai argumen yang akan menghasilkan teks di PyTorch dan menyimpan nilai yang dihasilkan di “ masukan_yang dikodekan ' variabel:

masukan_yang dikodekan = tokenizer ( gen_teks , return_tensors = 'pt' )Terakhir, lewati “ masukan_yang dikodekan ” variabel yang menyimpan teks yang disesuaikan ke “ model ” sebagai parameter dan dapatkan keluaran yang dihasilkan menggunakan “ panjang maksimal ” argumen yang disetel ke “ dua puluh ” yang menunjukkan bahwa teks yang dihasilkan akan dibatasi pada token yang disediakan, “ nomor_return_sequences ” yang disetel ke “ 5 ” yang menunjukkan bahwa teks yang dihasilkan akan mengandalkan 5 urutan teks:

keluaran = model ( **masukan_yang dikodekan )generator ( gen_teks , panjang maksimal = dua puluh , nomor_return_sequences = 5 )

Keluaran

Bagaimana Cara Memanfaatkan Model Berbasis Transformer untuk Menghasilkan Teks di TensorFlow?

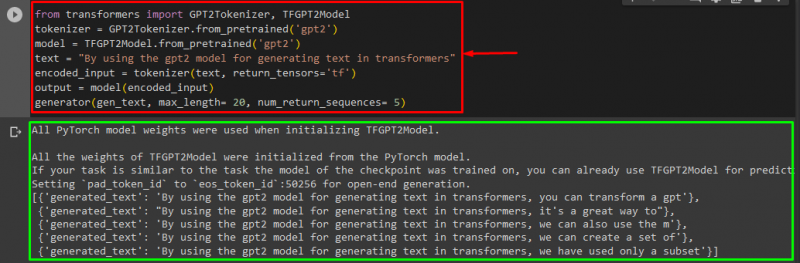

Untuk menghasilkan teks di Transformers, tombol “ Aliran Tensor Kerangka kerja pembelajaran mesin berbasis ” juga digunakan. Untuk melakukannya, pertama-tama, impor fungsi yang diperlukan, seperti “ GPT2Tokenizer ' Dan ' TFGPT2Model ' dari ' transformator ”. Kode selebihnya sama seperti di atas, hanya saja kita menggunakan “ TFGPT2Model ” fungsi alih-alih “ GPT2Model ' fungsi. Sebagai berikut:

dari transformator impor GPT2Tokenizer , TFGPT2Modeltokenizer = GPT2Tokenizer. dari_dilatih sebelumnya ( 'gpt2' )

model = TFGPT2Model. dari_dilatih sebelumnya ( 'gpt2' )

teks = 'Dengan menggunakan model gpt2 untuk menghasilkan teks di transformator'

masukan_yang dikodekan = tokenizer ( teks , return_tensors = 'tf' )

keluaran = model ( masukan_yang dikodekan )

generator ( gen_teks , panjang maksimal = dua puluh , nomor_return_sequences = 5 )

Seperti yang Anda lihat, teks yang disesuaikan telah berhasil dibuat:

Itu dia! Kami telah menguraikan tentang penyesuaian pembuatan teks di Transformers.

Kesimpulan

Untuk menyesuaikan pembuatan teks di Transformers, ada berbagai cara seperti memuat model dengan fungsi pipeline, menggunakan model berbasis transformator di “ PyTorch ' Dan ' Aliran Tensor ” yang didasarkan pada kerangka pembelajaran mesin. Dalam panduan ini, kami telah memberikan informasi singkat beserta demonstrasi praktis cara menyesuaikan pembuatan teks di Transformers.